Desde que la IA se hizo accesible al público general, el prompt engineering (ingeniera de prompts en español) ha tenido un auge en la cantidad de personas que buscan especializarse en la estructuración de prompts para optimizar su interacción con las herramientas de IA.

Y es que, para nadie es un secreto que las plataformas impulsadas con esta tecnología se han convertido en parte de nuestra rutina diaria, bien sea con fines investigativos o para llevar a cabo alguna tarea especifica.

Por ello resulta importante saber cómo crear prompts más eficientes y que aprovechen al máximo las capacidades que nos brindan los modelos de lenguaje. Con esta guía de prompting para LLMs te contamos cómo hacerlo.

Principios Básicos al Crear Prompts Para Modelos de Lenguaje

Principios Básicos de un Buen Prompt

Al momento de diseñar un prompt es importante que su estructura cumpla con los siguientes criterios:

Contexto

Establecer el contexto con claridad es algo necesario en todo prompt que hagas ya que constituye el punto de partida que conducirá al modelo de lenguaje a brindar una respuesta coherente.

Escribir un prompt sin este ingrediente puede hacer que la herramienta de IA con la que interactúes genere información irrelevante o ambigua.

Dentro del prompt engineering el contexto cumple la función de referencia semántica puesto que deja en claro quien habla, el asunto tratado y el tono requerido.

Un ejemplo puede ser cuando haces la redacción para solicitar una descripción de producto en el que como contexto incluyes el tipo de articulo, el público objetivo al que va dirigido y el formato especifico.

Instrucciones

Son los comandos estructurados que marcan la acción del LLM y le conduce para generar el resultado esperado.

Siempre ten en cuenta que las instrucciones claras y especificas son las que ayudan al LLM a ser eficiente en su trabajo.

De modo que al componer las instrucciones para LLMs, asegúrate de no caer en ambigüedades y manejar un lenguaje que vaya directo al grano, sin rodeos.

En el prompt engineering las instrucciones deben apegarse a los siguientes principios:

- Las oraciones deben contener verbos de acción concretos.

- Las oraciones deben tener establecido el formato del resultado (lista, código, tabla, texto breve, etc.).

- En caso de ser relevante el tono o estilo deben estar especificado en las oraciones (técnico, formal, narrativo)

Restricciones

Las restricciones representan el componente del prompt que marcan los limites en la respuesta generada por el modelo de lenguaje.

En el proceso de crear un prompt siempre habrá la necesidad de establecer el alcance que tendrá nuestra solicitud al LLM, de modo que nos brinde exactamente lo que queremos.

Esto puede significar fijar limites de extensión, de idioma o mantener ciertos temas fuera del campo de accion del modelo de lenguaje.

Cuando haces esto estas controlando la salida y mejorando la precisión del modelo. Dentro del prompt engineering, las restricciones sirven como filtros que potencian la confiabilidad del resultado generado por la herramienta de IA.

Cuando haces un prompt con todos estos elementos, no solo estas facilitando al LLM su tarea, sino tambien mejoras tus habilidades al adoptar mejores practicas de prompt engineering.

Prompt Engineering: Técnicas Avanzadas Para Crear Prompts Poderosos

Muchas personas piensan que el proceso de creación de prompts solo requiere escribir la orden que queremos darle al modelo de lenguaje y ya.

Lo cierto es que hay una serie de técnicas de diseño de prompts enmarcadas dentro del prompt engineering que optimizan su efecto sobre la herramienta de IA y te brindan un control más refinado de su comportamiento. Conozcamos cuales son estos tipos de prompting para LLMs en detalle:

Few-Shot

En esta técnica brindas al modelo de lenguaje algunos ejemplos (tres a cinco) que le enseñen la manera de llevar a cabo una tarea especifica.

Vale mencionar que estos ejemplos deben acompañar a las instrucciones principales. Con la técnica del few-shot ayudarás al LLM a identificar patrones, estilos y formatos.

También, estarás contribuyendo a optimizar notablemente su precisión y coherencia en la generación de texto, así como en tareas complejas o cuyos datos de entrada requieran múltiples cambios.

Imagina que estas solicitando al modelo de lenguaje la clasificación de mensajes.

Aplicando la técnica del few-shot tendrías que incluir tres ejemplos previos y luego pedir al LLM que haga la clasificación de uno adicional a ver si cumple con la premisa de los ejemplos proporcionados.

Chain of Thought (CoT)

A través de la técnica chain of thought (CoT) que forma parte de las estrategias de prompting efectivas para LLMs, adoptarás un enfoque en el que conducirás el comportamiento del modelo de lenguaje para que te brinde un razonamiento por etapas previo a una respuesta final.

Por lo que, al aplicar esta técnica de prompting, en vez de brindarte una respuesta directa, el modelo deconstruye tu petición en fases lógicas y expone su proceso de pensamiento de manera explícita.

De ese modo el LLM te ofrece una explicación de su razonamiento antes de responder, lo cual contribuye a mejorar la coherencia, precisión y transparencia del resultado.

Aplicando esta técnica puedes hacer un prompt indicándole al modelo que simule ser un experto en matemáticas y te brinde la solución a un problema, pero no sin antes explicar paso a paso el razonamiento que le condujo a la respuesta final:

El problema sería: Si un tren recorre 100 kilómetros en 2 horas ¿Cuál sería su velocidad promedio?

Este prompt lo acompañarías de instrucciones donde le indiques al modelo que identifique la formula usada para calcular la velocidad promedio, reemplace los valores correspondientes, lleve a cabo el cálculo paso a paso y por último explique el razonamiento que le condujo a la respuesta.

Prompt Chaining

Otra técnica que forma parte del concepto de prompt engineering es el prompt chaining. Su aplicación consiste en brindar al modelo de lenguaje instrucciones para que divida una tarea compleja en tareas de menor complejidad pero que mantengan una conexión entre si.

Esto significa que cada prompt es hecho a partir del resultado generado del prompt anterior.

De esa forma se crean una cadena de prompts que brindan al LLM una guía estructurada que lo conduzca de forma progresiva al resultado final deseado.

Un ejemplo podría ser hacer un prompt solicitando a una herramienta de IA que genere un esquema.

Luego pedir que redacte un contenido para dicho esquema. Seguido a esto hacer otro prompt pidiéndole al modelo de lenguaje que optimice el texto y por último otro prompt solicitándole evaluar su calidad.

Cuáles son los Errores Comunes en Prompts y Cómo Evitarlos

Cuáles son los Errores Comunes en el Diseño de Prompts y Cómo Evitarlos

Cometer errores al diseñar prompts para LLMs puede perjudicar notablemente la precisión y la coherencia de las respuestas generadas. Algunos de los errores más comunes y que deberás evitar para garantizar un óptimo desempeño del modelo de lenguaje son:

- Instrucciones vagas o contradictorias: Hacer prompts con falta de claridad sobre lo que deseas puede provocar interpretaciones dispares en el modelo de lenguaje.

- Ausencia de contexto: Un prompt sin contexto hará que el modelo de lenguaje no sepa a que estas refiriéndote.

- Uso excesivo de palabras ambiguas: Utilizar palabras como «interesante» o «bueno» en el diseño del prompt sin establecer ningún criterio puede hacer que el modelo de lenguaje te brinde una respuesta incoherente.

- Prompts excesivamente largos: Hacer prompts con demasiada carga de instrucciones puede hacer que el modelo de lenguaje pierda el foco de la tarea principal.

Por tanto, para obtener mejores resultados del LLM es necesario que implementes alguna de estas técnicas enmarcadas dentro del prompt engineering de manera que diseñes prompts optimizados que hagan a estas plataformas de IA conversacional desglosar tareas complejas.

Herramientas/Asistentes Donde Diseñar Prompts Efectivos Para LLMs

Existen plataformas y asistentes donde puedes encontrar prompts o mejorarlos para optimizar tu interacción con los modelos de lenguaje.

Con estas herramientas de prompting para LLMs podrás estructurar instrucciones efectivas que te ayudarán a guiar su comportamiento y así obtener lo que necesitas. Entre las herramientas más destacadas para conseguirlo están:

PromptPerfect

Se trata de una herramienta que pone a tu disposición un entorno donde optimizar tus prompts para que puedas luego ejecutarlos en diversos LLMs como ChatGPT, Midjourney, GPT-4, entre otros.

Aquí puedes ajustar la sintaxis de tus prompts para potenciar la precisión y obtener respuestas más elaboradas de los modelos de lenguaje.

En pocos segundos pasarás de hacer prompts simples con frases breves a prompts cargados de detalle y más efectivos.

FlowGPT

Es una plataforma comunitaria en la que podrás compartir y evaluar tus prompts.

Allí como el resto de usuarios podrás publicar tus mejores prompts para LLMs, así como también ver y evaluar los de otros usuarios. Puedes también usarlos como inspiración para optimizar los tuyos.

De modo que en FlowGPT descubres y aprendes las mejores prácticas de prompt engineering para LLMs en diferentes contextos.

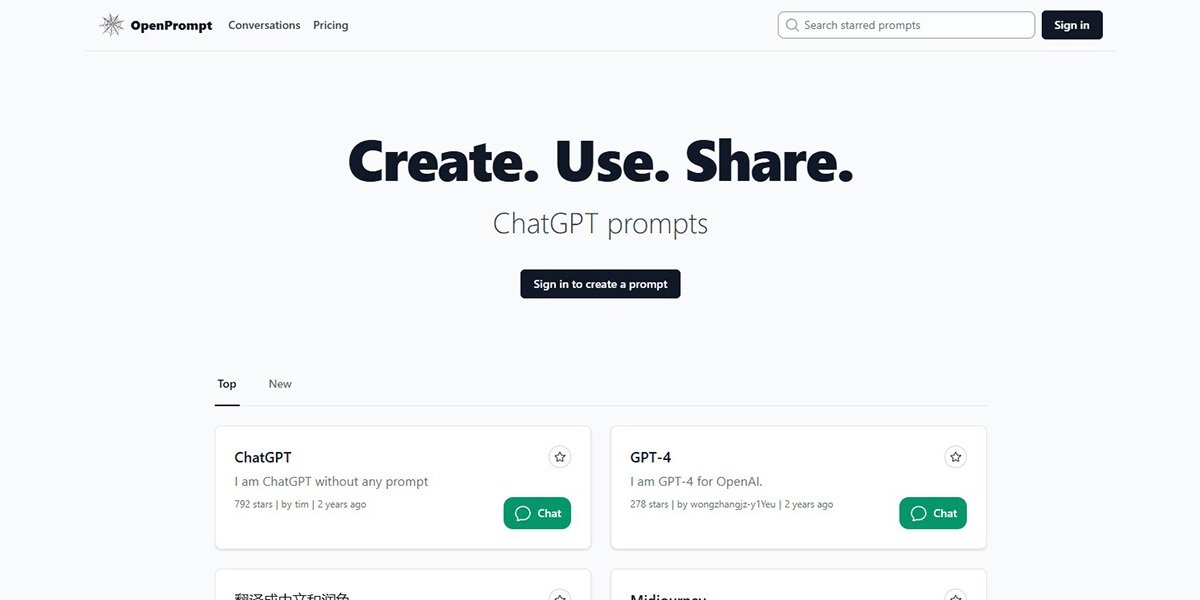

OpenPrompt

En este entorno orientado a la experimentación gratuita y abierta encontrarás herramientas y librerías que te servirán de complemento para diseñar los mejores prompts, compartirlos con otros usuarios e implementarlos luego en LLMs open-source.

Herramienta para Prompt Engineering OpenPrompt

Tambien puedes inspirarte explorando los prompts publicados por otros usuarios en esta plataforma o tomar alguno para adaptarlo a tus necesidades.

LangChain

Aquí dispondrás de una biblioteca y framework para la creación de aplicaciones interactivas basadas en modelos de lenguaje.

Eso significa que podrás aprovechar los recursos que te brinda esta plataforma para hacer prompt engineering en español.

Es así como en LangChain podrás diseñar flujos de trabajo complejos a partir de prompts encadenados con la técnica de prompt chaining.

En esta plataforma puedes tambien hacer integración de memoria y manejo de contexto.

Ejemplos de Prompts Optimizados

A continuación, veamos algunos ejemplos de prompting para LLMs optimizados en diferentes formatos. Así tendrás una idea de lo que puedes hacer cuando te abres camino en el mundo del prompt engineering y aprendes cómo diseñar prompts efectivos para LLMs:

Ejemplo 1 – Texto:

«Redacta una introducción breve sobre el impacto del aprendizaje automático en marketing digital, usando lenguaje técnico y tono persuasivo».

Ejemplo 2 – Imagen:

«Genera una ilustración realista de un robot humanoide interactuando con un diseñador frente a una interfaz de IA».

Ejemplo 3 – Multimodal:

«Analiza esta imagen y describe en texto las emociones que expresa el sujeto basándote en teoría de reconocimiento facial».

Todos estos ejemplos son una muestra de la efectividad que tiene el adquirir conocimientos de prompt engineering en español para ayudarte a diseñar prompts optimizados para LLMs en este y otros idiomas.

Puntos Clave

- La ingeniería de prompts para inteligencia artificial representa un excelente camino a seguir, no solo para aprender como optimizar los prompts con los que tendrás una interacción más productiva con los LLMs, sino también para sacar el máximo provecho de estos y obtener respuestas aún más elaboradas.

- Técnicas como few-shot, chain of thought y prompt chaining te ayudan a elevar la calidad de tus prompts y hacen que el comportamiento del LLM sea más optimo, brindándote las respuestas que necesitas en el formato deseado.

- Con ayuda de las herramientas de prompting para modelos de lenguaje lograrás diseñar prompts a la medida de tus necesidades, de manera que puedas obtener toda la información que necesitas o cumplir una tarea especifica de forma eficiente y rápida.

- Asegúrate de crear prompts que tengan contexto, instrucciones precisas y restricciones claras de modo que esto facilite el trabajo realizado por el LLM y te brinde respuestas coherentes y eficientes.